Entropie

Z Multimediaexpo.cz

Entropie je jedním ze základních a nejdůležitějších pojmů ve fyzice, teorii pravděpodobnosti a teorii informace, matematice a mnoha dalších oblastech vědy teoretické i aplikované. Setkáváme se s ní všude tam, kde hovoříme o pravděpodobnosti možných stavů daného systému či soustavy.

V populárních výkladech se často vyskytuje přiblížení entropie jako veličiny udávající "míru neuspořádanosti" zkoumaného systému. Není to dobré vysvětlení, neboť tato "definice" používá pojem "neuspořádanost", který je však sám nedefinovaný. Vhodnější je intuitivní představa entropie jako míry neurčitosti systému. Zatímco "ostrá" rozdělení pravděpodobnosti (jako např. prahování) mají entropii nízkou, naopak "neostrá" či "rozmazaná" rozdělení pravděpodobnosti mají entropii vysokou. Za pravděpodobnostní rozložení s nejvyšší entropií lze považovat normální (pro danou střední hodnotu a směrodatnou odchylku) nebo rovnoměrné (pro daný interval) rozložení.

Původ slova "entropie" je odvozen z řeckého εντροπία, "směrem k", (εν- "k" + τροπή "směrem").[1]

Obsah[skrýt] |

Historie

Pojem (termodynamické) entropie zavedl Rudolf Clausius v kontextu klasické termodynamiky s cílem vysvětlit, proč některé procesy jsou spontánní a jiné nejsou.

Mikroskopickou definici entropie předložil Ludwig Boltzmann v roce 1887, jako jeden z centrálních pojmů jím založeného nového oboru fyziky - statistické mechaniky.

Definice

V případě diskrétních stavů i pravděpodobností je entropie nejčastěji definovaná (Josiah Willard Gibbs) jako veličina typu:

- <math>S = - k\sum_i P_i \ln P_i \!</math>

kde S je obecně používaný symbol pro entropii. Sumace se provádí přes všechny mikrostavy, odpovídající zadanému makrostavu, a <math>P_i~</math> je pravděpodobnost i-tého mikrostavu. Konstanta k odpovídá volbě jednotek, ve kterých entropii S měříme. V jednotkách SI máme k = kB = Boltzmannova konstanta = 1.38066×10−23 J K−1. Jednotka entropie je tedy formálně stejná, jako jednotka tepelné kapacity. V jednotkách bit je k = 1/ln(2), takže

- <math>S = -\sum P_i \log_2 P_i</math>.

Z matematického pohledu je tedy entropie určitý aditivní funkcionál na pravděpodobnostních rozděleních. Z pohledu fyziky je entropie klíčová veličina pro formulaci druhého zákona termodynamiky. Tento zákon klade principiální meze pro možnost získat z termodynamické soustavy užitečnou práci.[2][3] Pojem entropie a druhý zákon termodynamiky může být také uplatněn k řešení otázky, jestli daný proces bude probíhat spontánně. Spontánní procesy v uzavřených soustavách vždy odpovídají vzrůstu entropie.

V případě izolovaného systému v rovnováze (Boltzmann) platí:

- <math>S = k_{\mathrm{B}} \ln \Omega \, ,</math>

kde <math>\Omega \,</math> je systému dostupná část fázového prostoru (u stejnocenných mikrostavů se jedná jednoduše o počet rozlišitelných mikrostavů daného makroskopického stavu systému).

Termodynamická entropie

Termodynamickou entropii lze vyjádřit pomocí tepla <math>Q</math> a teploty <math>T</math> v diferenciálním tvaru jako

- <math>\mathrm{d}S = \frac{\delta Q}{T}</math>

Podíl tepla <math>Q</math> a teploty <math>T</math> bývá také označován jako redukované teplo. Při Carnotově cyklu je součet redukovaných tepel roven nule. Vzhledem k tomu, že libovolný vratný cyklus je možné aproximovat elementárními Carnotovými cykly, jejichž redukované teplo lze vyjádřit jako <math>\frac{\delta Q}{T}</math>, je možné předchozí tvrzení zobecnit na libovolný vratný cyklus.

Proběhnutí všech elementárních Carnotových cyklů je pak ekvivalentní aproximovanému vratnému ději, což lze vyjádřit jako

- <math>\sum \frac{\delta Q}{T} = 0</math>

Postupným zmenšováním elementárních Carnotových cyklů se v limitě dostaneme k výrazu

- <math>\oint \frac{\delta Q}{T} = 0</math>

Tento vztah je označován jako Clausiova rovnice a představuje podmínku, která je platná pro libovolný vratný kruhový děj. Tuto rovnici lze považovat za matematické vyjádření druhé hlavní věty termodynamiky.

Z předchozího vztahu je vidět, že všechna <math>\delta Q</math> nemohou být kladná, ale některá musí být i záporná. Soustava, která vykonává vratný kruhový děj tedy nemůže od okolních těles teplo pouze přijímat, ale musí jim také nějaké teplo odevzdávat.

Princip růstu entropie

Entropie je veličina s velkým významem, neboť umožňuje formulovat druhou hlavní větu termodynamiky, a vyjádřit kvantitativně nevratnost tepelných pochodů. Tuto skutečnost vyjadřuje princip růstu entropie.

Za příklad nevratného děje můžeme považovat pokles závaží spojený s uvolněním jisté potenciální energie. Pokud klesne závaží o určitou výšku <math>h</math> a je zastaveno třením, vykoná práci <math>W</math>, při které třením vznikne teplo <math>Q = W</math>. Toto teplo odvedeme do okolí, které lze považovat za těleso s teplotou <math>T</math>, a jehož entropie se tím změní o hodnotu <math>\Delta S=\frac{Q}{T}</math>. Předpokládáme přitom, že teplota okolí se přidáním tepla <math>Q</math> nijak znatelně nezmění. Přivedené teplo je kladné, a proto je také změna entropie kladná. Entropie soustavy tedy při tomto nevratném ději vzrostla.

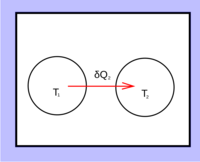

Uvažujme tepelně izolovanou soustavu dvou těles 1 a 2 s teplotami <math>T_1</math> a <math>T_2</math>.

Tělesa si mohou vyměňovat tepelnou energii, přičemž celková hodnota tepelné energie zůstává stálá. Získá-li těleso 2 o teplotě <math>T_2</math> teplo <math>\delta Q_2</math>, musí těleso 1 stejně velké teplo odevzdat, tzn. <math>\delta Q_2=-\delta Q_1</math>. Bude tedy platit <math>\delta Q_1+\delta Q_2=0</math>.

Změna entropie bude

- <math>\mathrm{d}S = \mathrm{d}S_1+\mathrm{d}S_2 = \frac{\delta Q_1}{T_1} + \frac{\delta Q_2}{T_2} = \left(\frac{1}{T_1}-\frac{1}{T_2}\right) \delta Q_1 = \frac{T_2-T_1}{T_1T_2} \delta Q_1</math>

Z tohoto vztahu je vidět, že pokud mají výraz <math>T_2-T_1</math> a teplo <math>\delta Q_1</math> stejné znaménko, pak <math>\mathrm{d}S>0</math>, jinak <math>\mathrm{d}S<0</math>. Podle Clausiovy formulace druhé hlavní věty však teplo nemůže samovolně přecházet z tělesa chladnějšího na těleso teplejší. Je-li tedy <math>T_2>T_1</math>, nemůže teplo přejít z tělesa 1 na těleso 2, a proto musí být <math>\delta Q_1>0</math>, tzn. <math>\delta Q_2<0</math>. Pokud však <math>T_2<T_1</math>, nemůže teplo přejít z tělesa 2 na těleso 1, takže musí být <math>\delta Q_1<0</math>, tedy <math>\delta Q_2>0</math>. V obou případech mají <math>T_2-T_1</math> a <math>\delta Q_1</math> stejná znaménka, což znamená, že v izolované soustavě platí

- <math>\mathrm{d}S>0</math>

Celková entropie izolované soustavy dvou těles různých teplot tedy roste. Jsou-li teploty dosti blízké, nebo jsou-li tělesa od sebe dostatečně dobře izolována, může být změna entropie libovolně malá. V takové soustavě prakticky nedochází k výměně tepla a soustava je blízká tepelné rovnováze. Děje, které probíhají v takové soustavě, lze považovat za vratné, a jejich entropie se téměř nemění. Při vratném adiabatickém ději může být tedy entropie stálá, avšak nikdy nemůže klesat.

V tepelně izolované soustavě probíhají děje adiabatické. V každé soustavě mohou z počátečního stavu vzniknout různé stavy vratnou nebo nevratnou změnou. Stavy, kterých soustava dosáhne nevratnou změnou, se podle druhé termodynamické věty liší od stavů při vratné změně tím, že z nich soustava sama od sebe bez vnějšího zásahu nemůže přejít zpět do výchozího stavu. Mimoto jsou zde stavy, z nichž lze počátečního stavu soustavy dosáhnout nevratnou změnou. Tyto stavy však soustava nemůže z počátečního stavu dosáhnout bez vnějšího zásahu. Odsud plyne další možné vyjádření druhé hlavní věty termodynamiky: V blízkosti každého stavu soustavy existují stavy, kterých nelze dosáhnout adiabatickým dějem. Takové stavy jsou tedy v izolované soustavě vyloučeny.

Podle Carnotovy věty je účinnost nevratného kruhového děje mezi teplotami <math>T_1</math> a <math>T_2</math> vždy nižší než účinnost vratného Carnotova cyklu mezi stejnými teplotami. Pokud tedy pracovní látka získá při nevratném ději teplo <math>Q_1</math> a odvede teplo <math>Q_2^\prime</math>, bude platit

- <math>\frac{Q_2^\prime}{Q_1} > \frac{T_2}{T_1}</math>

Vydané teplo <math>Q_2^\prime</math> je vlastně záporné přijaté teplo, tzn. <math>Q_2^\prime = -Q_2</math>, tzn.

- <math>\frac{Q_1}{T_1} + \frac{Q_2}{T_2}<0</math>

Pokud děj neprobíhá pouze mezi dvěma teplotami, ale při spojitě se měnících teplotách, přejde předchozí součet v limitě na integrál po uzavřené cestě

- <math>\oint_{(nevrat)} \frac{\delta Q}{T} < 0</math>

Tento vztah se obvykle zapisuje ve tvaru

- <math>\oint \frac{\delta Q}{T}\le 0</math>,

kde znaménko rovnosti platí pro vratný kruhový děj. Jde vlastně o vyjádření skutečnosti, že při libovolném kruhovém ději, při němž se teplo mění v mechanickou energii, nemohou být všechna <math>\delta Q</math>, která soustava přijímá, kladná, ale některá musí být také záporná. Část tepla tedy musí soustava odvádět, takže se všechno přijaté teplo nezužitkuje pro mechanickou energii. Pokud při nevratném ději působí tření, takže vykonaná práce je menší a v soustavě vzniká třením teplo, je třeba k dosažení výchozího stavu odvádět více tepla než při vratném kruhovém ději, což je vyjádřeno znaménkem nerovnosti.

Pokud se entropie procesu zvyšuje, je tento proces nevratný (ireverzibilní). Pokud zůstává konstantní, je tento proces vratný (reverzibilní), jako např. u ideálního Carnotova kruhového děje.

Celková entropie uzavřeného systému se nemůže nikdy zmenšit. V přírodě tedy všechny děje směřují do více neuspořádaného stavu. Stejně tak roste entropie ve vesmíru. Dle předpokladů L. Boltzmana se jeví jako nejpravděpodobnější konečný stav vyrovnání pohybových energií molekul. To znamená, že by se konečné hodnoty entropie ve vesmíru dosáhlo tehdy, kdyby se vyrovnaly veškeré teplotní rozdíly (tepelná smrt).

Informační entropie

Informační entropie velmi úzce souvisí s termodynamickou entropií, ačkoliv toto spojení se ukázalo být zřejmé až po mnoha letech nezávislého studia termodynamické entropie a informační entropie. Často je také nazývána Shannonovou entropií po Claude E. Shannonovi, který zformuloval mnoho klíčových poznatků teoretické informatiky. Obecně pro systém s konečným počtem možných stavů <math>S\in\{s_1,s_2,...,s_n\}, n\leq \infty</math> a pravděpodobnostní distribucí <math>P(s_i)</math> je informační entropie definována jako střední hodnota:

- <math>H(S)=-\sum_{i=1}^n P(s_i)\log_{2}P(s_i)</math>

Zde formálně definujeme, že <math>0\cdot \log_{2}0\equiv 0</math>.

Entropie je maximální pro rovnoměrné rozložení <math>P(s_i)=\frac{1}{n} \mbox{ pro } \forall{i}</math>:

- <math>H(S)=-\sum_{i=1}^n \frac{1}{n}\log_{2}\frac{1}{n}=-\log_{2}\frac{1}{n}=\log_{2}n</math>,

a minimální pro zcela deterministický systém <math>\exists P(s_k)=1\mbox{ a }P(s_i)=0 \mbox{ pro } \forall{i} \neq k</math>:

- <math>H(S)=-\sum_{i=1}^n P(s_i)\log_{2}P(s_i)=-\log_{2}1 = 0</math>.

Stručně řečeno, entropie je střední hodnota informace jednoho kódovaného znaku. Míra entropie souvisí s problematikou generování sekvence náhodných čísel (resp. pseudonáhodných čísel), protože sekvence naprosto náhodných čísel by měla mít maximální míru entropie. Shannonova entropie také tvoří limit při bezeztrátové kompresi dat, laicky řečeno, komprimovaná data nelze beze ztráty informace „zhustit“ více, než dovoluje jejich entropie.

Jako jistou míru vzdálenosti mezi dvěma rozděleními pravděpodobnosti lze definovat relativní entropii[4] a to následovně: nechť p = p(x) a q = q(x) jsou dvě rozdělení pravděpodobnosti na množině <math> \scriptstyle \mathcal{X}</math> a q(x) > 0 pro všechna <math> \scriptstyle x \in \mathcal{X}</math>. Pak relativní entropii rozdělení p a q definujeme jako

- <math>D(p\|q) = D(p(x) \| q(y)) = \sum_{x \in \mathcal{X}} p(x) \log \frac{p(x)}{q(x)}.</math>

Odvození entropie

Podobně jako ve fyzice lze vztah pro entropii odvodit kombinatoricky s použitím Stirlingova vzorce (na levé straně vzorečku je počet možných textů nad nějakou abecedou vzhledem k nějakému diskrétnímu pravděpodobnostnímu rozdělení):[5]

<math>\log \sqrt[N]{N \choose n_1,\ldots,n_k} \approx -\sum_{i=1}^k p_i\log p_i</math>

kde <math>n_i</math> je počet výskytů i-tého znaku a <math>N</math> délka textu.

Reference

- ↑ Entropy [online]. Online Etymology Dictionary, [cit. 2008-08-05]. Dostupné online.

- ↑ DAINTITH, John. Oxford Dictionary of Physics. [s.l.] : Oxford University Press, 2005. ISBN 0-19-280628-9.

- ↑ Explicitněji řečeno, energie TRS je coby užitečná práce nedostupná, přičemž TR je teplota nejchladnějšího vnějšího rezervoáru tepla.

- ↑ Vajda I., Teorie informace. Vydavatelství ČVUT, Praha 2004. ISBN 80-01-02986-7

- ↑ http://www.billix.eu/entropy.html Multinomiální odvození entropie

Externí odkazy

- Entropie v encyklopedii MathWorld (anglicky)

- SKÁCEL, Dalibor. Co to je entropie?. Alternativní energie [online]. 2002-03-21. Dostupné online.

| [zobrazit] Náklady na energie a provoz naší encyklopedie prudce vzrostly. Potřebujeme vaši podporu... Kolik ?? To je na Vás. Náš FIO účet — 2500575897 / 2010 |

|---|